Google Search Console Der Ultimative Anfänger Guide Teil 3

Google Search Console / Webmaster Tools der ultimative Anfänger Guide Teil 3

Im zweiten Teil haben wir uns mit den entstandenen Suchanfragen aus einander gesetzt und außerdem den Indexierungsstatus deiner Webseite analysiert. In diesem dritten und letzten Teil beschäftigen wir uns mit dem wohl wichtigsten Teil, dem Crawling. Ohne Crawling, also den virtuellen Besuch des Google-Bots auf eurer Webseite, kann keine Indexierung passieren, weil Google sonst eure Webseite gar nicht kennt.

Crawling

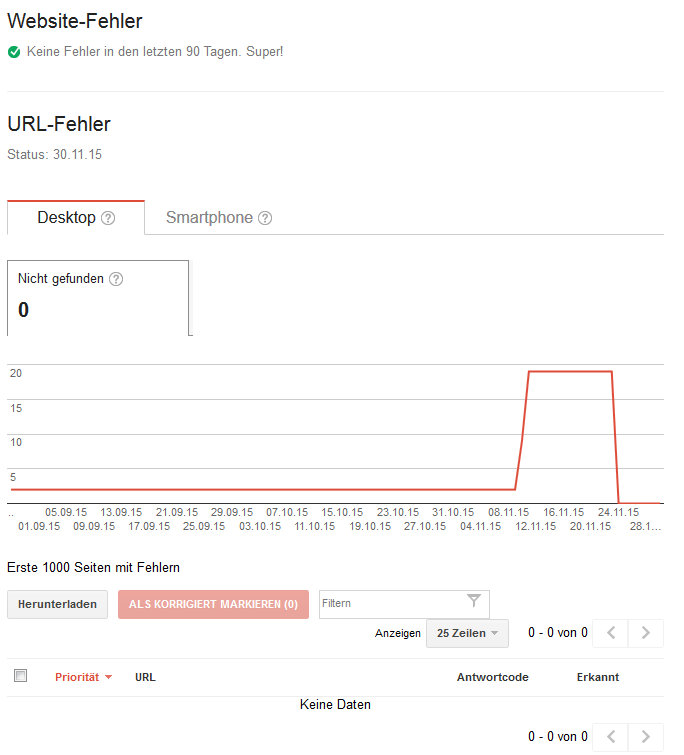

Crawling-Fehler

In diesem Bereich werden, wie der Name schon sagt, Fehler angezeigt, die beim Crawlen deiner Webseite entstanden sind. Dabei wird allerdings zwischen Fehlern unterschieden, die beim Desktop, Mobil und bei Feature Phone auftreten. Feature Phone sind zwischen einem herkömmlichen Handy und einem Smartphone einzuordnen. Der häufigste Fehler, den du hier sehen wirst, ist der 404-Fehler. Dieser sagt aus, dass der Google-Bot eine Seite nicht finden konnte. Dieser Fehler tritt meistens dann auf, wenn andere Webseiten auf eine deiner Unterseiten verlinken, die nicht mehr existiert. Was du hier machen solltest, ist herauszufinden welche Webseite diesen Link gesetzt hat. Anschließend sollte der Webmaster der Webseite mit der Bitte kontaktiert werden, den Link auf eine gültige Seite abzuändern. Wenn dies aus irgendeinem Grund nicht gehen sollte oder sehr viele unterschiedliche Webseiten auf eine nicht existierende Seite verweisen, solltest du die ankommende URL eigenständig auf eine gültige umleiten.

In diesem Bereich werden, wie der Name schon sagt, Fehler angezeigt, die beim Crawlen deiner Webseite entstanden sind. Dabei wird allerdings zwischen Fehlern unterschieden, die beim Desktop, Mobil und bei Feature Phone auftreten. Feature Phone sind zwischen einem herkömmlichen Handy und einem Smartphone einzuordnen. Der häufigste Fehler, den du hier sehen wirst, ist der 404-Fehler. Dieser sagt aus, dass der Google-Bot eine Seite nicht finden konnte. Dieser Fehler tritt meistens dann auf, wenn andere Webseiten auf eine deiner Unterseiten verlinken, die nicht mehr existiert. Was du hier machen solltest, ist herauszufinden welche Webseite diesen Link gesetzt hat. Anschließend sollte der Webmaster der Webseite mit der Bitte kontaktiert werden, den Link auf eine gültige Seite abzuändern. Wenn dies aus irgendeinem Grund nicht gehen sollte oder sehr viele unterschiedliche Webseiten auf eine nicht existierende Seite verweisen, solltest du die ankommende URL eigenständig auf eine gültige umleiten.

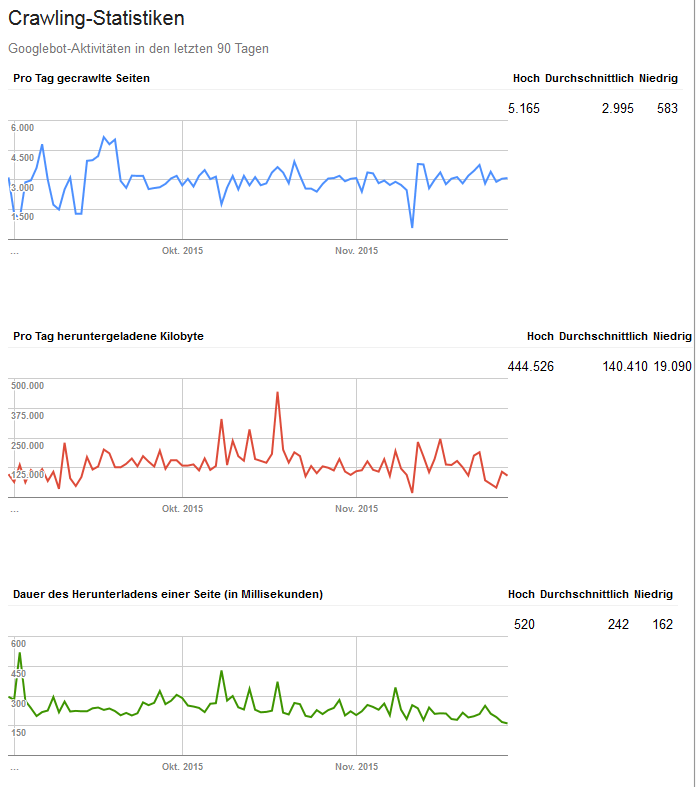

Crawling-Statistik

Wenn deine Webseite auf mehrere hundert Seiten angewachsen ist, sollte der Google-Crawler in einem täglichen oder wöchentlichen Rhythmus deine Seite besuchen, je nachdem wie oft du neue Inhalte veröffentlichst. Die Crawlhäufigkeit, täglich geladene Datengröße und die dafür benötigte Zeit kannst du in diesem Bereich prüfen.

Wenn deine Webseite auf mehrere hundert Seiten angewachsen ist, sollte der Google-Crawler in einem täglichen oder wöchentlichen Rhythmus deine Seite besuchen, je nachdem wie oft du neue Inhalte veröffentlichst. Die Crawlhäufigkeit, täglich geladene Datengröße und die dafür benötigte Zeit kannst du in diesem Bereich prüfen.

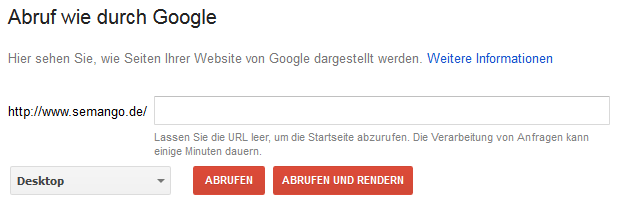

Abruf Wie Durch Google

Das Tool „Abruf wie durch Google“ kann für unterschiedliche Zwecke angewendet werden. Durch die Möglichkeit direkt eine URL von seiner Webseite eingeben zu können, kann der Google Crawler direkt zu der eigenen Startseite oder Unterseite gesendet werden. Dies kann sehr nützlich sein, wenn bspw. eine neue Unterseite angelegt oder Änderungen an einer bestehenden Seite vorgenommen wurden und genau diese Änderungen so schnell wie möglich in den Index von Google gelangen müssen. Die eigentliche Funktion ist, die Google wahrscheinlich auch vorgesehen hat, dass durch die Eingabe einer URL das Tool den Inhalt anzeigt, was der Google Crawler sieht, wenn er die Seite besucht. Dies ist sehr wertvoll um herauszufinden, ob die eigene Webseite mit Malware befallen ist. Denn diese stellt Inhalte nur für den Suchmaschinen Crawler dar und verstößt somit gegen die Google Richtlinien. Diese Technik nennt sich cloaking.

Für welchen Zweck das Tool auch verwendet wird, der Ablauf ist immer derselbe. Für eine Unterseite wird der Pfad nach der Domain in das Eingabefeld eingegeben, für die Startseite lässt man ihn leer und wählt anschließend den User-Agent aus. Zur Auswahl stehen der normale Desktop, Smartphone, XHTML/WML und cHTML. Die ersten Beiden sollten jedem ein Begriff sein. Die letzten beiden sind eine spezielle Variante für Mobile Devices, die Webseiten mit hohen Datenmengen reduziert darstellen, indem Bilder und andere größere Ressourcen nicht geladen werden. Nachdem der benötigte User-Agent ausgewählt wurde, wird die URL durch einen Klick auf „ABRUFEN“ eingereicht. Nach einigen Sekunden sollte dann das Ergebnis angezeigt werden. Wenn die URL an den Index gesendet werden soll, kann dies durch den Klick auf die entsprechende Schaltfläche initiiert werden. Anschließend öffnet sich ein Pop-Up, wo lediglich noch ausgewählt werden muss, ob nur die Seite an den Index gesendet werden soll oder alle Seiten, die auf der Seite verlinkt sind.

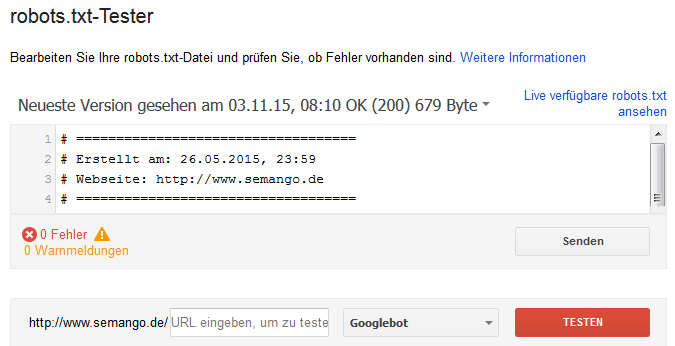

Robots.Txt-Tester

Es wird einige Seiten auf deiner Webseite geben, die du nicht indexiert haben möchtest. Dies könnten bspw. Login-Bereiche, RSS-Feeds oder kritische Inhalte sein, die nicht öffentlich zugänglich sein sollen. Durch die Einrichtung einer robots.txt kannst du nicht nur Google, sondern auch alle anderen Suchmaschinen und Bots den Zugriff verwehren. Im Normalfall halten sich die Crawler an die Anweisungen, wenn du aber tatsächlich für niemanden Daten öffentlich zugänglich aufbewahren möchtest, solltest du die Verzeichnisse mit einem Passwortschutz versehen.

Es wird einige Seiten auf deiner Webseite geben, die du nicht indexiert haben möchtest. Dies könnten bspw. Login-Bereiche, RSS-Feeds oder kritische Inhalte sein, die nicht öffentlich zugänglich sein sollen. Durch die Einrichtung einer robots.txt kannst du nicht nur Google, sondern auch alle anderen Suchmaschinen und Bots den Zugriff verwehren. Im Normalfall halten sich die Crawler an die Anweisungen, wenn du aber tatsächlich für niemanden Daten öffentlich zugänglich aufbewahren möchtest, solltest du die Verzeichnisse mit einem Passwortschutz versehen.

Mit dem robots.txt – Tester ist es möglich die Validität der robots.txt – Datei zu testen. Dabei kann nicht nur die bestehende Datei getestet werden, sondern falls noch keine existiert, eine neue angelegt oder eben eine bestehende direkt verändert werden. Dieses Tool ist sehr nützlich und deswegen sehr empfehlenswert zu verwenden. Denn das letzte was wir wollen, ist die Indexierung unserer Webseite zu gefährden oder dass die falschen Seiten in den Index aufgenommen werden. Durch dieses Tool können wir mit Googles Augen auf die Seiten schauen und die Indexierung etwas steuern.

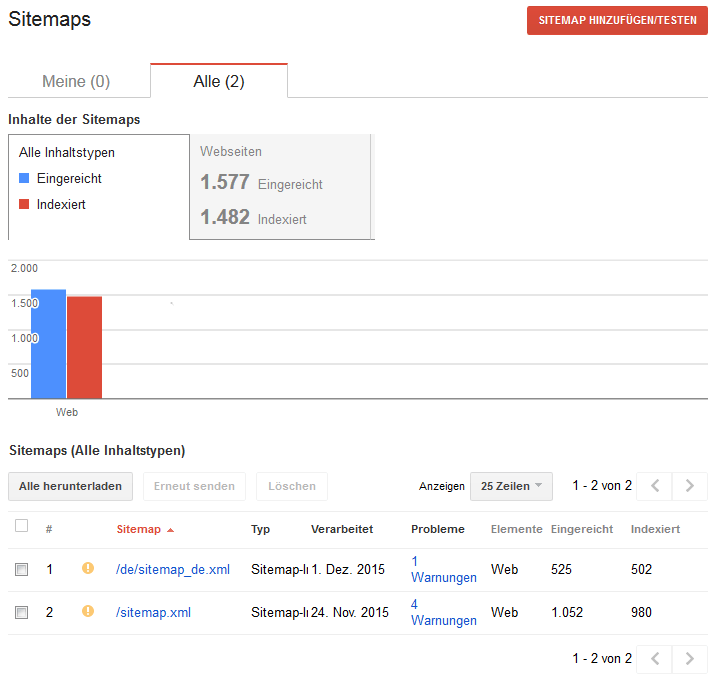

Sitemaps

Durch das Einreichen einer Sitemap helfen wir Google zu erkennen, welche unterschiedlichen Unterseiten es auf unserer Webseite gibt und vereinfachen und beschleunigen eventuell somit auch die Indexierung. Wenn du keine Sitemap einreichst, ist die Wahrscheinlichkeit sehr groß, dass Google nicht alle Unterseiten indexiert. Das bedeutet, dass dir potenzielle Besucher und somit Traffic entgehen.

Durch das Einreichen einer Sitemap helfen wir Google zu erkennen, welche unterschiedlichen Unterseiten es auf unserer Webseite gibt und vereinfachen und beschleunigen eventuell somit auch die Indexierung. Wenn du keine Sitemap einreichst, ist die Wahrscheinlichkeit sehr groß, dass Google nicht alle Unterseiten indexiert. Das bedeutet, dass dir potenzielle Besucher und somit Traffic entgehen.

Sitemaps müssen im XML-Format eingereicht werden. Sie haben eine Limitierung von max. 50.000 URLs oder 10 MB Dateigröße. Wenn eines dieser beiden Limitierungen erreicht wird, muss die Sitemap in mehrere Dateien aufgeteilt werden. Wenn du technisch nicht sehr versiert bist, dann kannst du dir einfach eine sitemap generieren lassen. Alles was du hierfür machen musst, ist deine URL einzugeben und auf „Start“ zu klicken.

Nachdem deine Sitemap hochgeladen wurde, wird dir Google anzeigen wieviel URLs davon indexiert worden sind. Wunder dich allerdings nicht, wenn nicht sofort alle eingereichten Seiten indexiert werden. Es ist üblich, dass Google nicht alle eingereichten Seiten indexiert. Allerdings sollte dein Ziel natürlich sein, soviel Seiten wie möglich zu indexieren. Wenn irgendwelche Seiten nicht in den Index aufgenommen werden, liegt es typischerweise daran, dass der Inhalt nicht einzigartig ist, die title- und description-Tags generisch sind und die Webseite nicht genug externe Verlinkungen und somit aus Google Sicht nicht relevant erscheint.

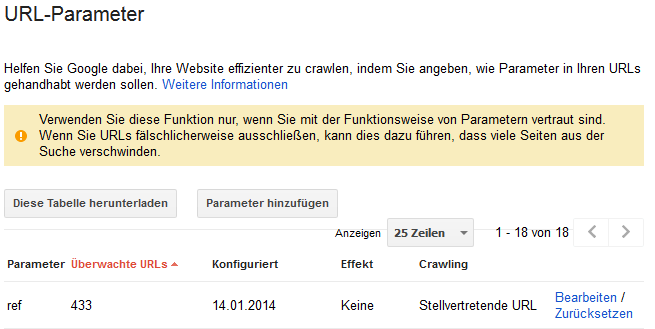

URL-Parameter

URL-Parameter werden am Ende einer URL nach einem Fragezeichen angegeben. Solche Parameter haben unterschiedliche Funktionen bspw. kann damit eine Sortierung auf der Webseite angestoßen werden oder ein vorhandener Filter bereits voreingestellt werden Oft werden Tracking Informationen oder andere nur für den Webseitenbetreiber relevante Informationen angehangen. Somit gibt es Parameter, die den Inhalt einer Webseite nicht beeinflussen und welche, die den Inhalt verändern. Der aufmerksame Leser ahnt bereits worauf ich hinaus will, nämlich auf das Duplicate-Content Problem, welches durch die Parameter entsteht. Die Parameter, die den Inhalt nicht beeinflussen modifizieren also die URL und somit ist derselbe Inhalt mit als auch ohne Parameter erreichbar. Für genau solche Zwecke ist dieser Menüpunkt. Dort können die verwendeten Parameter angegeben und ebenfalls eingestellt werden, ob sie den Inhalt beeinflussen. So weiß der Crawler, ob es eigenständige Seiten oder eventuell nur inhaltlich gesehen irrelevante Informationen sind.

URL-Parameter werden am Ende einer URL nach einem Fragezeichen angegeben. Solche Parameter haben unterschiedliche Funktionen bspw. kann damit eine Sortierung auf der Webseite angestoßen werden oder ein vorhandener Filter bereits voreingestellt werden Oft werden Tracking Informationen oder andere nur für den Webseitenbetreiber relevante Informationen angehangen. Somit gibt es Parameter, die den Inhalt einer Webseite nicht beeinflussen und welche, die den Inhalt verändern. Der aufmerksame Leser ahnt bereits worauf ich hinaus will, nämlich auf das Duplicate-Content Problem, welches durch die Parameter entsteht. Die Parameter, die den Inhalt nicht beeinflussen modifizieren also die URL und somit ist derselbe Inhalt mit als auch ohne Parameter erreichbar. Für genau solche Zwecke ist dieser Menüpunkt. Dort können die verwendeten Parameter angegeben und ebenfalls eingestellt werden, ob sie den Inhalt beeinflussen. So weiß der Crawler, ob es eigenständige Seiten oder eventuell nur inhaltlich gesehen irrelevante Informationen sind.

Sicherheitsprobleme

Jeder fühlt sich sicher, bis er einmal selbst betroffen ist! Die Gefahr, dass eine Webseite von schadhaften Code befallen wird, ist viel höher, als es sich die meisten Webseitenbetreiber vorstellen. Wenn eine Webseite von Malware befallen wird, bekommt Google das in der Regel relativ schnell mit und je nach Schwere des Falles kann es dazu führen, dass das Ranking nicht nur negativ beeinflusst wird, sondern dass die Webseite komplett aus den Index entfernt wird und das bei den organischen als auch bezahlten Suchergebnissen. Falls Google auf einer Webseite Malware feststellt, wird dies hier angezeigt.

Fazit

Die Search Console ist eine sehr nützliche Werkzeugsammlung für Webmaster, die sogar kostenlos ist. Wenn du sie noch nicht benutzt, solltest du nun damit anfangen. Die Werkzeuge sind sehr wertvoll, weil Google dir damit mögliche Fehler deiner Webseite anzeigt. Wenn du also deine Positionen bei Google analysieren und auch verbessern möchtest, solltest du die Infos aus der Search Console auf jeden Fall berücksichtigen.

Artikel Serie

Google Search Console: Der Ultimative Anfänger Guide Teil 1

Google Search Console: Der Ultimative Anfänger Guide Teil 2

Google Search Console: Der Ultimative Anfänger Guide Teil 3